서론

사용자 인터페이스(User Interface, UI)는 컴퓨터와 사용자 간의 의사소통을 위한 도구이다. 대표적인 사용자 인터페이스로서 컴퓨터에 명령어를 입력하기 위한 키보드가 주로 사용되어왔다. 또한 마이크로소프트 Windows와 같은 그래픽 기반 운영체제가 컴퓨터에 도입된 이후에는 마우스도 대표적인 사용자 인터페이스로 자리를 잡았다. 최근에는 3차원(3D) 그래픽스, 증강현실(augmented reality, AR), 가상현실(virtual reality, VR) 등과 같은 기술의 발전으로 공간적인 개념을 포함하는 비착용형 또는 착용형 3D 사용자 인터페이스에 관한 연구가 활발하게 진행되고 있다(Laviola et al., 2017).

비착용형 3D 사용자 인터페이스의 개발을 위해 마이크로소프트 키넥트(Kinect) 센서가 널리 활용되고 있다. 키넥트는 카메라를 이용하여 사용자의 움직임을 인식할 수 있는 센서이다(Kim, 2012). Boulos et al.(2011)은 키넥트 센서를 이용해서 양팔과 손의 움직임을 인식하여 Google Earth, Bing Maps 3D 등과 같은 3D 가상지구(virtual globe) 소프트웨어를 제어할 수 있는 3D 사용자 인터페이스를 개발하였다. 그 결과 마우스, 키보드와 같은 전통적인 사용자 인터페이스를 사용하지 않고 3D 가상지구 소프트웨어를 제어할 수 있었다. Lee and Jeon(2012)은 키넥트 센서를 이용하여 신체 움직임을 인식한 후, 신체 동작에 따라 Windows 환경에서 마우스 커서의 이동과 클릭 이벤트를 제어할 수 있는 3D 사용자 인터페이스를 개발하였다. Lee(2017)는 헤드 마운티드 디스플레이(head mounted display, HMD) 장치를 착용한 사용자의 양팔 움직임을 키넥트 센서로 인식하여 VR 환경에서 3D 지도 소프트웨어를 제어할 수 있는 3D 사용자 인터페이스를 개발하였다. 그러나 키넥트 센서를 기반으로 개발된 사용자 인터페이스들은 Windows 환경에서 마우스 커서의 이동을 통해 3D 소프트웨어를 제어하는 데에는 효과적이었지만, 클릭이나 드래그와 같은 반복적인 이벤트 처리를 통해 소프트웨어를 제어하는 데에는 효과적이지 못한 한계가 있었다.

대표적인 착용형 3D 사용자 인터페이스의 하나로서 손가락 움직임을 감지하는 센서들을 부착한 데이터 글러브가 사용되고 있다. Gallotti et al.(2011)은 가상의 스크린을 터치할 수 있는 데이터 글러브를 제작하여 3D 캐드(computer aided design, CAD) 소프트웨어를 제어하였다. 또한 소프트웨어 제어 정확도에 대하여 자이로스코프 3D 마우스와의 비교실험을 수행하였다. Silva et al.(2013)은 손가락의 구부러짐 정도를 측정할 수 있는 굽힘 감지 데이터 글러브를 이용하여 VR 환경에서 재활 치료를 위한 비디오 게임을 실행하였다. 또한 Nilsson and Öman(2016)은 굽힘 감지 데이터 글러브와 관성측정장치(inertial measurement unit, IMU)를 이용하여 무선조종 자동차를 원격 제어하였다. 데이터 글러브 기반의 착용형 3D 사용자 인터페이스는 손가락 동작을 이용하여 클릭이나 드래그와 같은 이벤트 처리를 정밀하게 수행할 수 있는 장점이 있으나, 손가락을 제외하면 사용자의 다른 신체 부위를 인식할 수 없어 3D 소프트웨어를 효과적으로 제어하기 어려운 한계가 있었다.

광업 분야에서도 3D 사용자 인터페이스 개발 및 활용을 위한 연구가 진행되었다. Bednarz et al.(2010)은 데이터 글러브와 스마트폰을 이용해서 몰입형 가상현실(immersive virtual reality) 환경에서 광산 장비를 원격 제어할 수 있는 3D 사용자 인터페이스를 개발하였다. 그러나 이 연구에 사용된 데이터 글러브는 스마트폰 화면의 터치스크린 기능만을 제공하였으며, 사용자 손가락의 세밀한 동작을 감지할 수 없었다. 또한 키넥트 센서 등을 통해 감지할 수 있는 사용자 신체 움직임 정보를 광업 분야 소프트웨어 제어를 위해 활용하지 못했다.

본 연구의 목적은 키넥트 센서와 굽힘 감지 데이터 글러브를 이용하여 지질 모델링, 광체 모델링, 광산 지하수위 모델링 등과 관련한 광업 분야 3D 소프트웨어를 직관적으로 제어할 수 있는 3D 사용자 인터페이스를 개발하는 것이다. 키넥트 센서를 이용하여 사용자의 신체 움직임을 감지하고, 이 움직임에 따라 Win32 API 함수를 호출하여 Windows 환경에서 마우스 커서의 이동을 제어하고자 한다. 또한 오픈소스 하드웨어인 아두이노 LilyPad 보드와 National Instrument의 LabVIEW를 이용하여 굽힘 감지 데이터 글러브를 제작하고, 글러브를 착용한 사용자의 손가락 굽힘 정도를 측정하여 소프트웨어 제어를 위해 필요한 클릭, 드래그 등의 이벤트를 처리할 것이다. 본 논문에서는 키넥트 센서 및 굽힘 감지 데이터 글러브 기반의 3D 사용자 인터페이스 개발 방법을 설명하고, 이를 Google Earth(Choiet al., 2012; Google, 2019), FROMS 3D(Nohet al., 2013), KmodStudio(KORES, 2016), GRAM for Windows(Choiet al., 2014; Kim and Choi, 2018) 소프트웨어에 적용해본 결과를 제시한다.

연구 방법

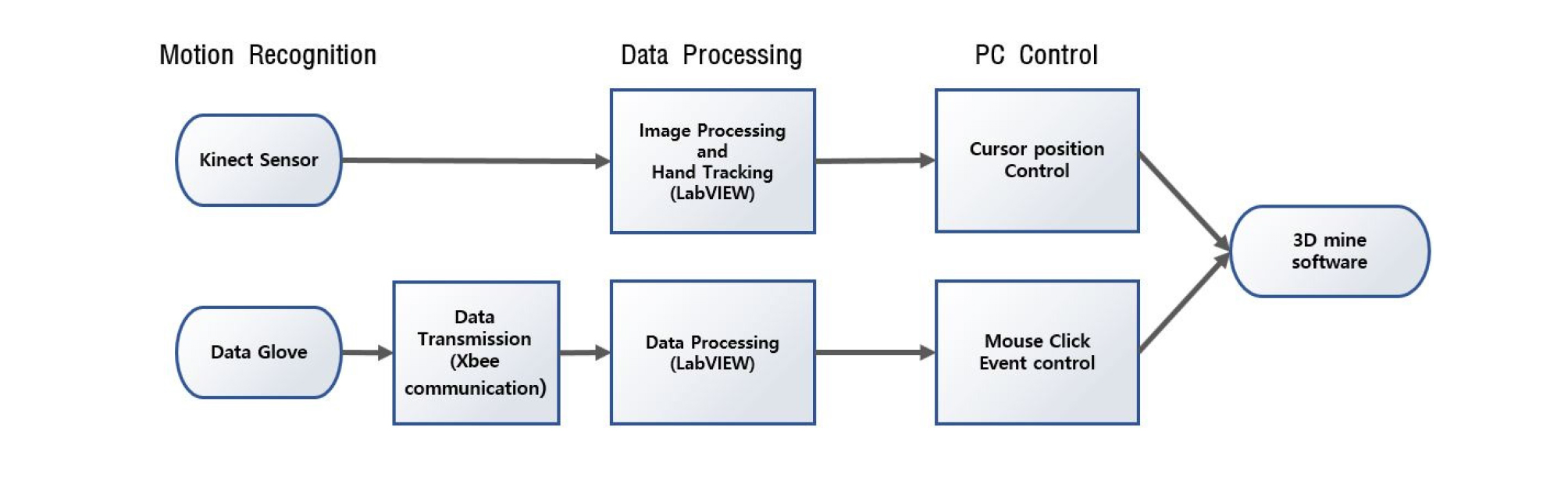

본 연구에서 설계한 3D 사용자 인터페이스의 구조는 동작인식, 자료처리, PC제어 파트로 구분된다(Fig. 1). 동작인식 파트에서는 키넥트 센서를 이용하여 사용자 신체의 컬러 영상과 깊이(depth) 영상을 획득하고, 굽힘 감지 센서를 이용해 사용자 손가락의 움직임을 인식한다. 그리고 그 신호를 Xbee(Zigbee) 통신을 통해 PC로 실시간 전송한다. 자료처리 파트에서는 PC에 전송된 영상과 신호를 바탕으로 사용자 손의 움직임과 손가락 굽힘 정도를 정량화한다. 마지막으로 PC제어 파트에서는 정량화된 사용자 손의 움직임과 손가락 굽힘 정도에 따라 Win32 API 함수를 호출하여 Windows 환경에서 마우스 커서의 이동과 클릭, 드래그 등의 이벤트를 제어한다. 이와 같은 방법으로 3D 사용자 인터페이스를 개발하여 사용자의 손동작과 손가락 움직임으로 광업 분야 3D 소프트웨어를 제어하고자 하였다.

키넥트 센서의 원리와 기능

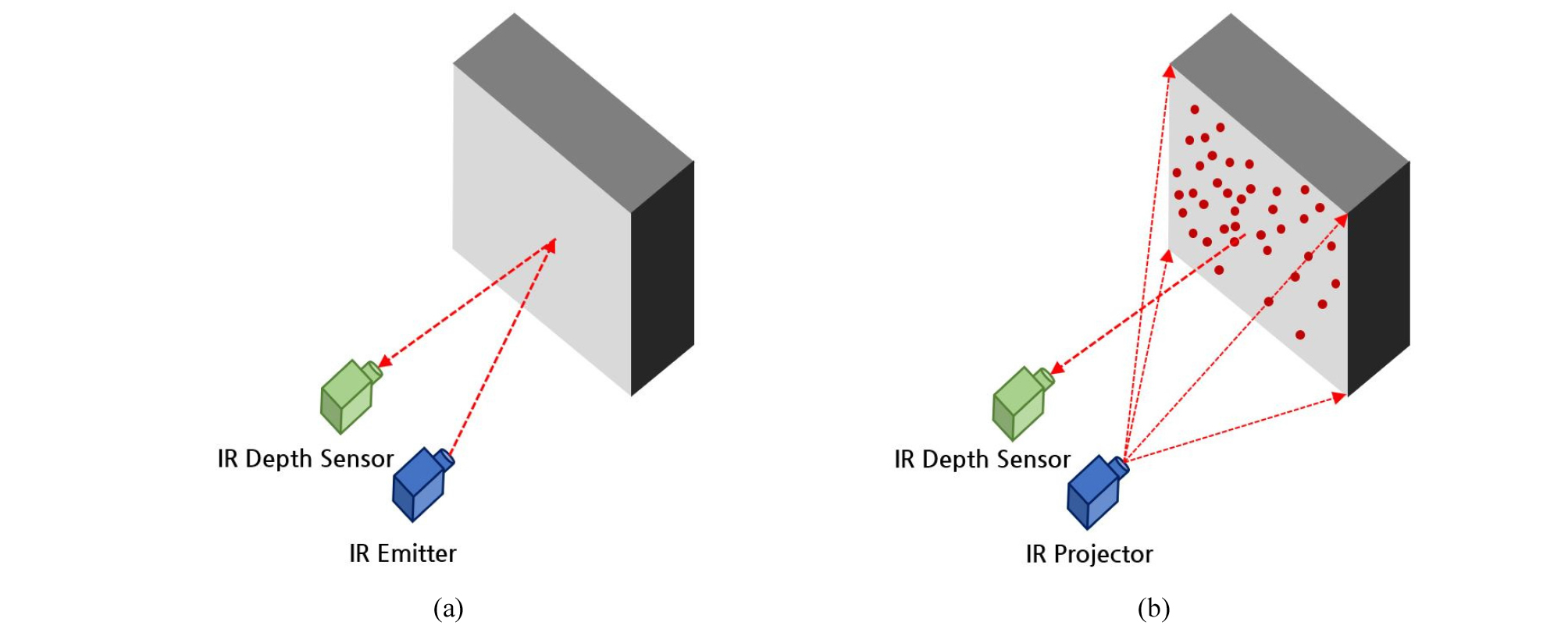

키넥트 센서와 같은 깊이 카메라(depth camera)를 이용하여 3D 깊이 정보를 추출하는 방법에는 Time of Flight(ToF) 방식과 구조광(structured light)을 이용하는 방식이 있다. Fig. 2에 제시된 바와 같이 적외선(infrared radiation, IR) 발생 장치에서 쏜 빛이 물체에 반사되어 IR 깊이 센서까지 도달하는데 걸리는 시간을 기준으로 깊이를 계산하는 것이 TOF 방식이며, IR 프로젝터에서 픽셀 단위로 쏜 적외선 점들이 물체에 맺힌 위치와 패턴을 분석하여 깊이 정보를 획득하는 것이 구조광 방식이다. 구체적으로 구조광 방식은 일정한 간격 및 패턴들로 송출되고 있는 적외선 점들이 물체에 투영되었을 때 점간의 간격이 좁아지거나 멀어지는 등의 특성을 분석하여 깊이 정보를 획득한다(Zhang, 2012). 본 연구에서는 구조광 방식을 사용하는 마이크로소프트 Kinect for Windows(V1) 센서를 이용하여 3D 사용자 인터페이스 개발을 수행하였다.

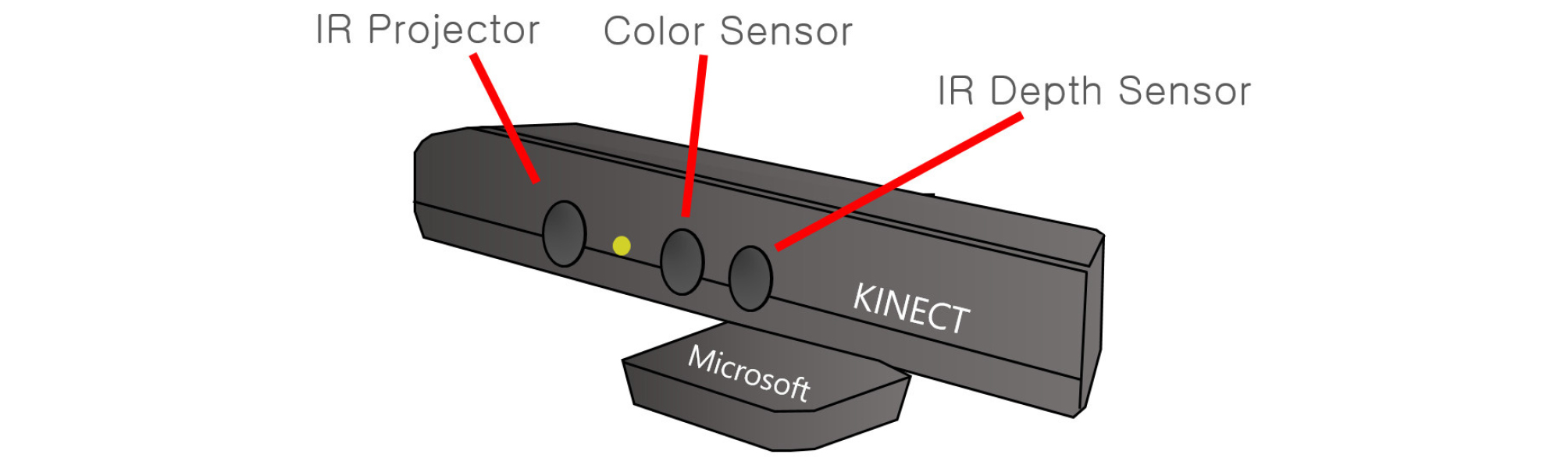

Fig. 3은 본 연구에서 사용한 Kinect for Windows(V1) 센서의 모식도이다. IR 프로젝터에서 송출한 픽셀 단위의 적외선 점들을 IR 깊이 센서로 인식한 후 점 패턴의 특성을 분석하여 깊이 정보를 획득한다. 컬러(color) 센서는 일반적인 RGB 영상을 획득하는 데 사용된다. 또한 마이크로폰을 통한 음성인식 기능과 틸트 모터(tilt motor)를 이용한 센서 높이 조절 기능을 함께 제공한다. 키넥트 센서는 사용자의 신체 부위를 20개의 골격으로 분류한 영상(skeleton view)을 이용하여 각각의 골격에 해당하는 위치정보들을 효과적으로 인식할 수 있는 장점이 있다.

키넥트 센서를 이용한 핸드 트래킹

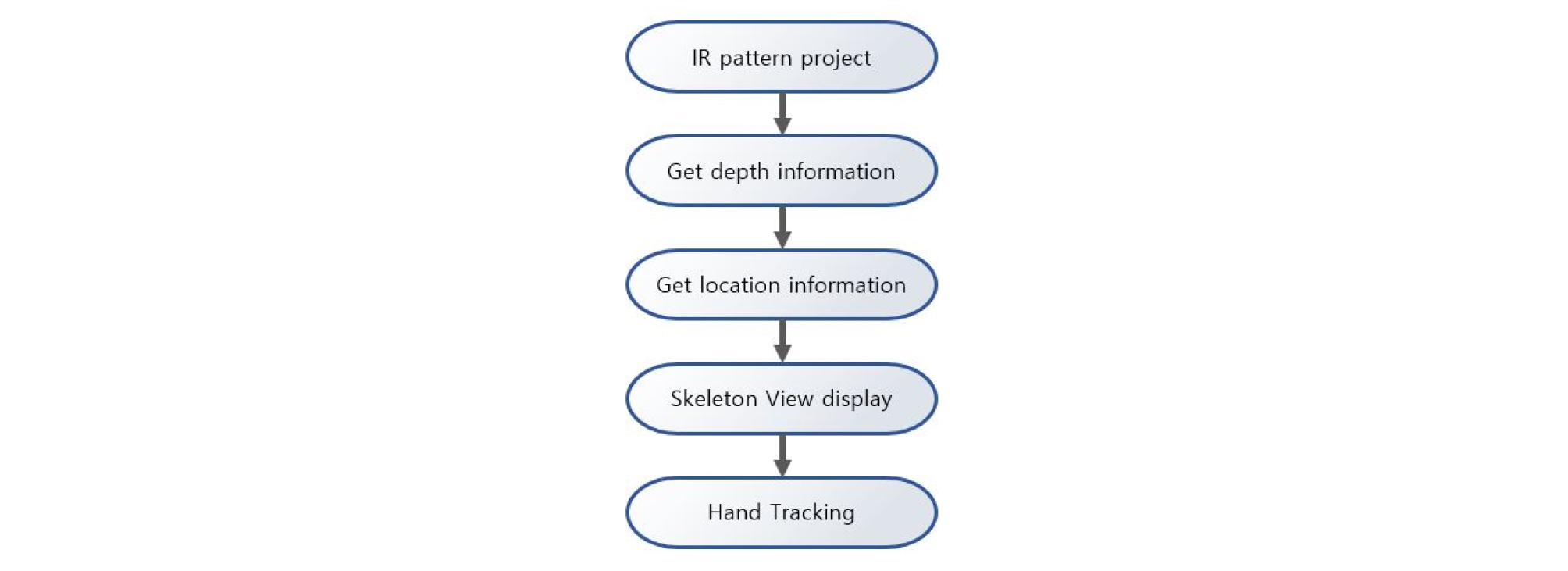

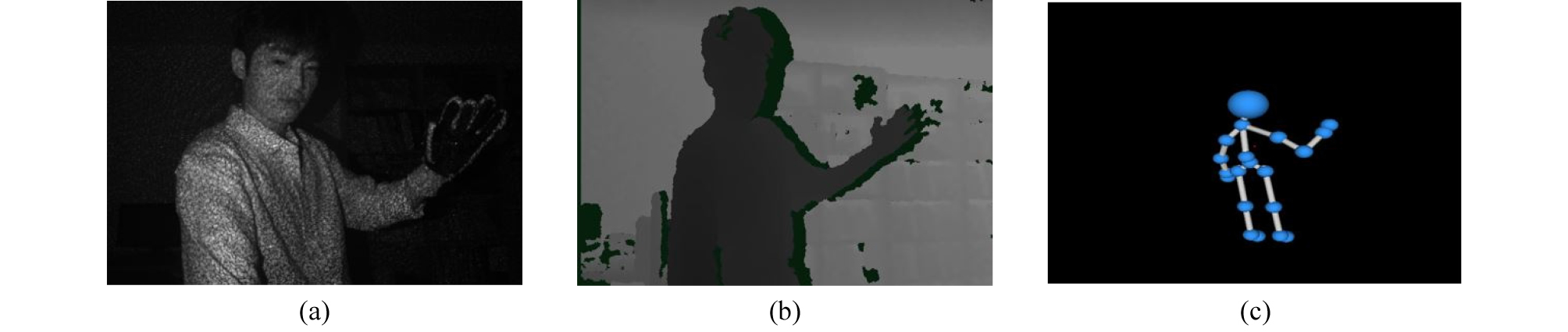

키넥트 센서에서 획득된 실시간 영상은 Fig. 4와 같은 방법으로 처리하였다. 먼저, IR 프로젝터에서 송출한 적외선 점 패턴을 IR 깊이 센서로 감지하여 깊이 영상을 획득하였다. 획득한 깊이 영상을 통해 사용자 신체를 인지하고, 20개 골격에 대한 위치정보를 획득하였다. 각각의 골격에 대한 위치정보를 하나의 객체 형태로 묶어서 인식한 후 골격 간의 연결부를 부드럽게 이어줌으로써 3차원 skeleton 영상을 생성하였다. 그리고 오른손의 위치정보를 실시간 추적할 수 있도록 하였다(Fig. 5). 실시간 추적되는 오른손의 위치정보는 Win32 API 중 마우스 커서의 위치를 변환시켜주는 SetCursorPos 함수를 호출하는 데 사용하였다. 또한 위치정보의 후처리를 통해 실제 오른손의 위치와 디스플레이 장치에서 마우스 커서의 위치를 일치시켜 주었다. 즉, 키넥트 센서를 이용하여 오른손 움직임을 추적하고 이를 통해 얻은 좌표정보 값을 이용하여 마우스 커서의 이동을 제어하였다.

아두이노 보드를 이용한 굽힘 감지 데이터 글러브 제작

굽힘 감지 데이터 글러브는 손가락의 굽힘 정도를 측정하는 부분과 측정된 값을 PC로 전송하는 부분으로 구성된다. 글러브를 착용한 사용자 손가락의 굽힘 정도에 따라 굽힘 감지 센서에서 아날로그 신호 형태의 저항값이 측정되며, 측정된 저항값을 디지털 신호로 변환한 후 무선통신을 통해 PC로 그 값을 전송한다. 실시간 전송되는 값들을 이용하여 Win32 API 함수를 호출하면 Windows 환경에서 마우스 클릭, 드래그 등의 이벤트를 제어할 수 있다.

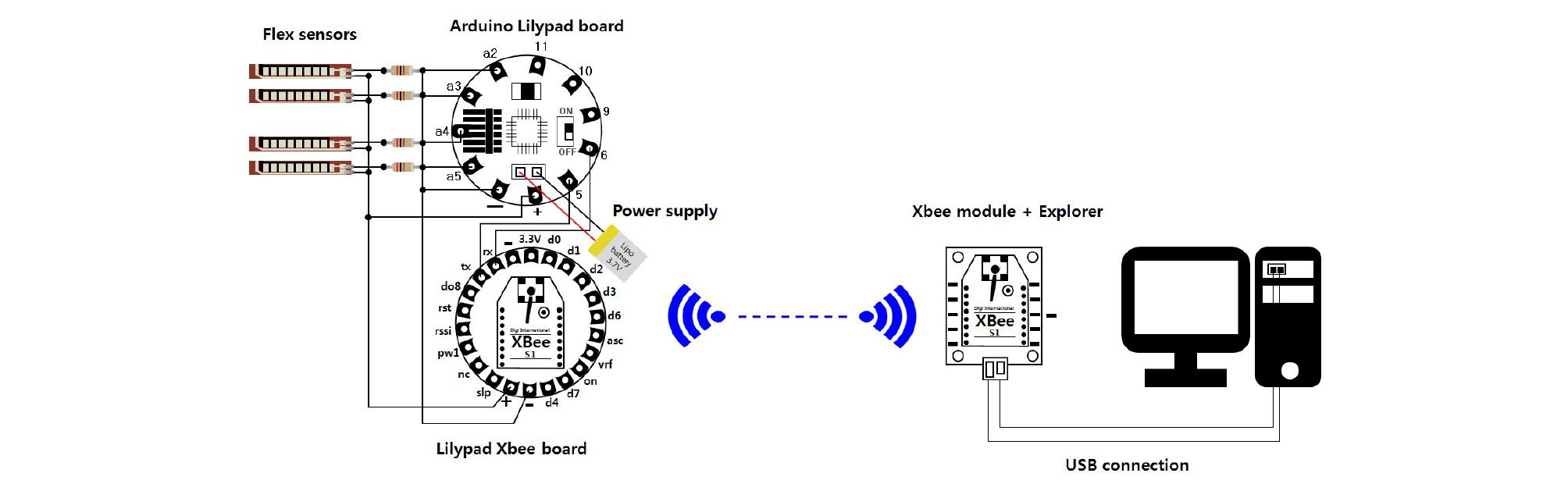

본 연구에서는 굽힘 감지 데이터 글러브 제작을 위해 Table 1과 같은 부품들을 사용하였다. 장갑에서 상대적으로 굽힘 동작이 어려운 약지를 제외하고 나머지 4개의 손가락 위치에 굽힘 감지 센서(flex sensor)를 부착하였다. 본 연구에서 사용한 굽힘 감지 센서는 Sparkfun사에서 제조한 SEN-08606 모델이며, 이 센서의 폭은 0.25인치, 길이는 4.5인치이다. 4개의 굽힘 감지 센서의 (+)핀은 아두이노 LilyPad 보드의 (+)핀 및 LilyPad Xbee 보드의 (+)핀과 연결하였다. 또한 굽힘 감지 센서의 (-)핀은 10KΩ의 저항과 연결한 후 아두이노 LilyPad 보드의 아날로그 핀 및 LilyPad Xbee 보드의 (-)핀에 연결하였다. 각각의 아날로그 핀들은 전류가 통하는 전도성 실로 바느질하여 연결해 주었으며, 굽힘 감지 센서와 10KΩ 저항은 납땜질하여 연결하였다. 다수의 전도성 실이 교차하지 않도록 구성하기 위해서 내부와 외부가 이중으로 구분된 이중외피 장갑을 사용하였다.

Table 1. Components of the bend-sensing data glove developed in this study.

디지털화된 굽힘 감지 신호를 PC로 전송하기 위해 아두이노 LilyPad 보드의 (5), (6)번 단자를 LilyPad Xbee 보드의 (tx), (rx)단자와 연결하였다. 또한 무선통신 설정을 위한 프로그래밍 코드를 아두이노 LilyPad 보드에 입력하기 위해서 FTDI Basic Breakout 모듈을 아두이노 LilyPad 보드에 연결하였고 이를 PC와 연결하였다. Xbee 무선통신을 위해 데이터 글러브에서는 LilyPad Xbee 보드와 Xbee 모듈을 연결하였으며, PC에서는 Xbee 모듈과 Xbee Explorer USB 모듈을 연결하였다. 데이터 글러브에 필요한 전력은 Lipo 배터리를 LilyPad 보드에 연결하여 공급하였다. Fig. 6은 앞서 설명한 굽힘 감지 데이터 글러브의 회로도를 보여준다.

데이터 글러브 이벤트 처리

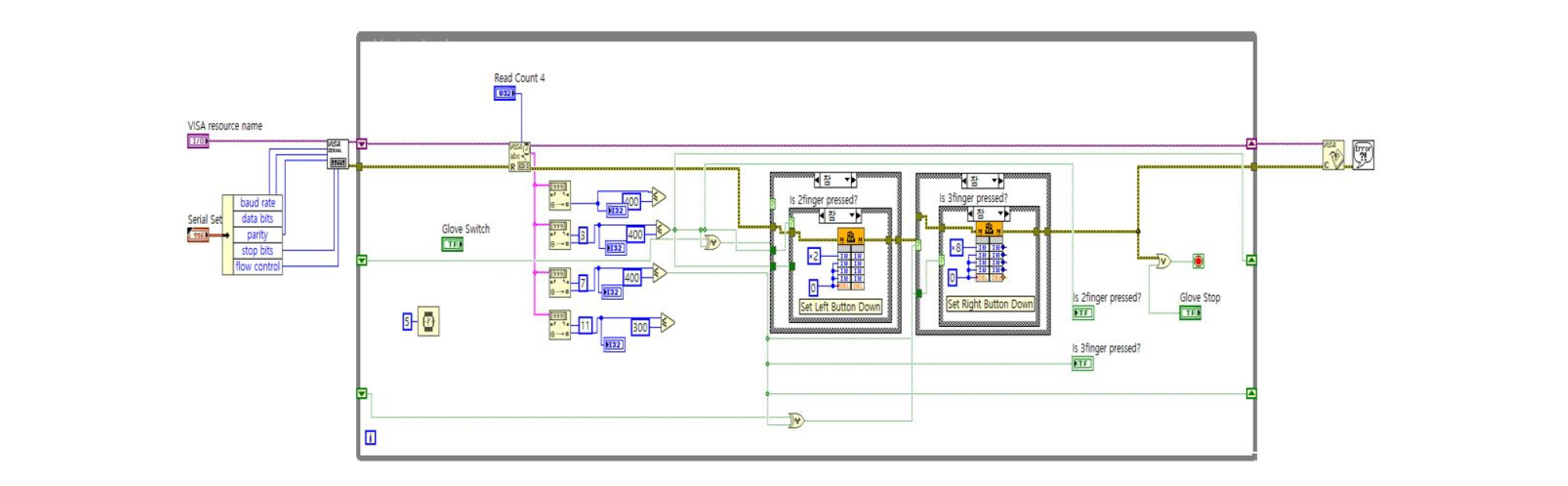

굽힘 감지 데이터 글러브로부터 PC로 전송된 디지털 신호를 처리하기 위해 LabVIEW 소프트웨어를 이용하여 이벤트 처리 프로그램을 개발하였다. 개발된 프로그램은 데이터 글러브에서 실시간 전송되는 디지털 신호 중 각각의 손가락의 굳힘 정도에 따라 발생하는 저항값들을 추출한다. 저항값은 약 200∼500 사이이며 손가락을 많이 굽힐수록 200에 가깝고, 펼수록 500에 가깝게 나타났다. 본 연구에서는 저항값 임계치를 400으로 설정하여 이보다 낮은 값이 나타나면 Win32 API의 Mouse_event 함수를 호출하여 마우스의 좌, 우 클릭 이벤트가 실행될 수 있도록 하였다. 본 연구에서는 Mouse_event 함수를 사용했으나 유사한 기능을 제공하는 SendInput 함수를 사용해도 마우스의 클릭 이벤트를 제어할 수 있다. 또한 신호가 연속적으로 수신되므로 직전 신호와 현재 신호 중 하나라도 400 이하의 값을 가지면 마우스의 클릭 이벤트를 유지하여 드래그 처리가 가능하도록 하였다. Fig. 7은 개발된 프로그램의 블록 다이어그램을 보여준다.

연구 결과

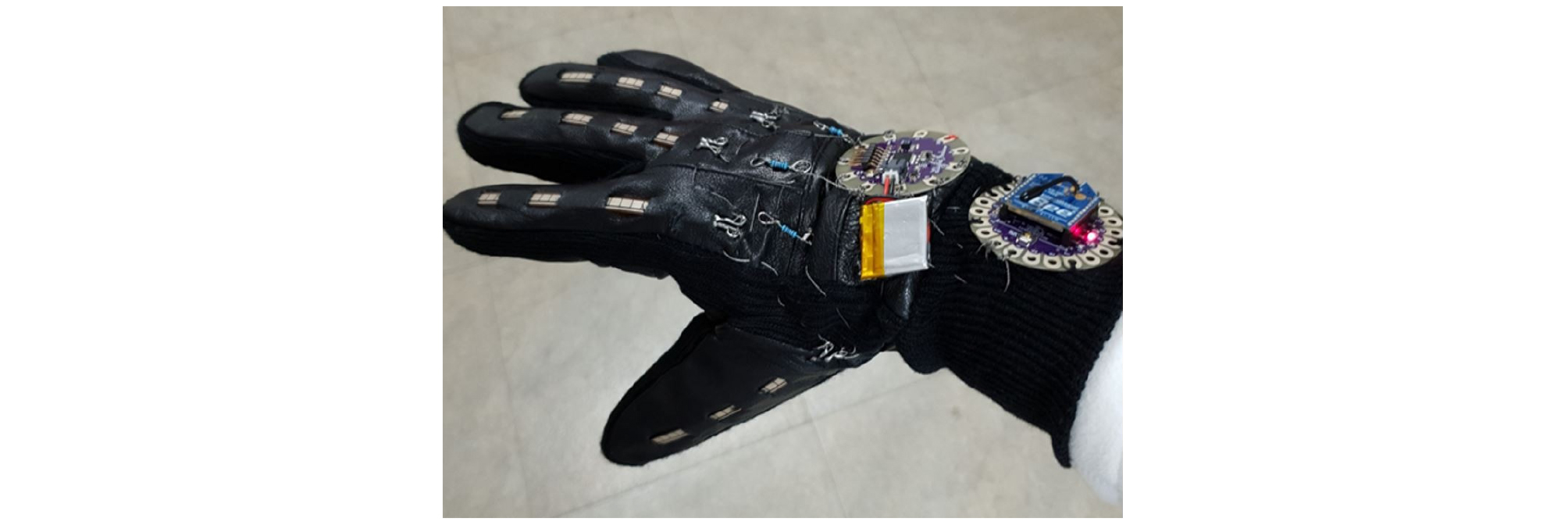

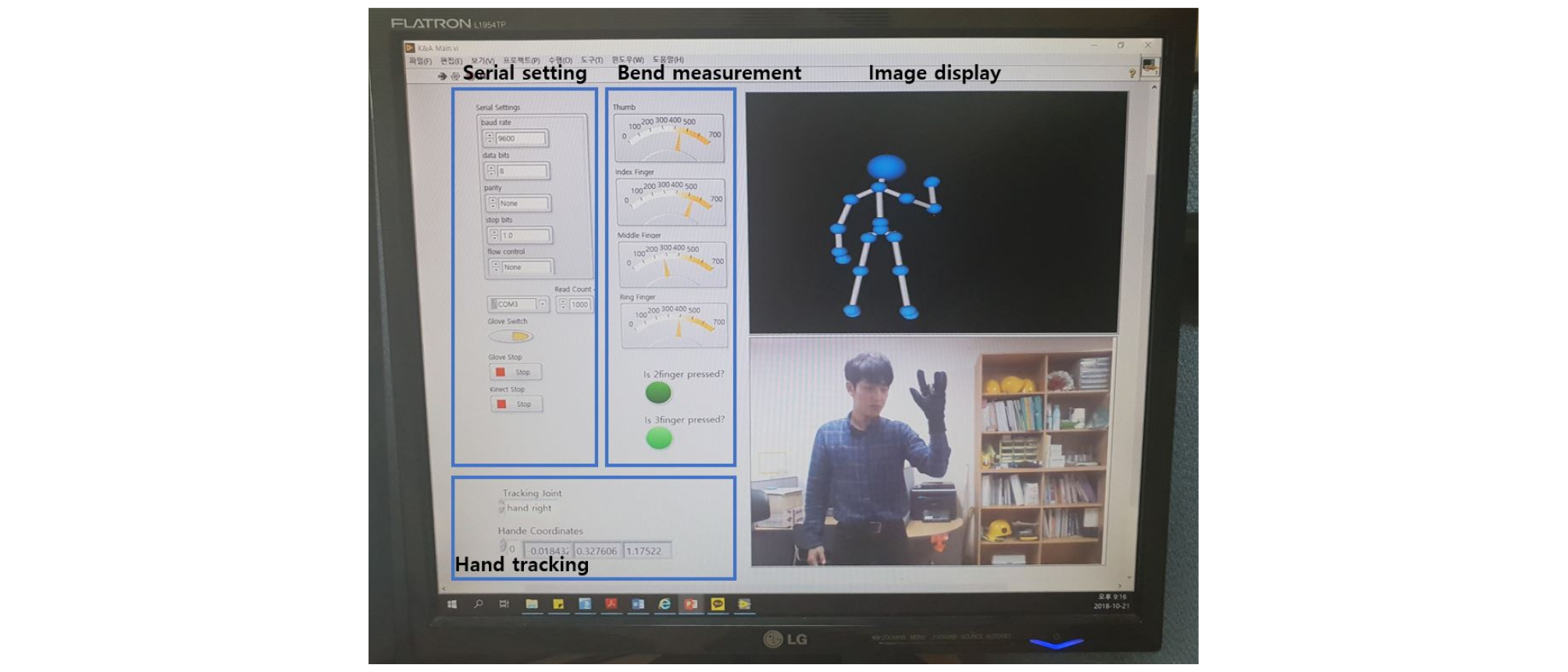

Fig. 8은 본 연구에서 제작한 굽힘 감지 데이터 글러브를 보여준다. 키넥트 센서와 굽힘 감지 데이터 글러브에서 PC로 전송되는 디지털 신호를 처리하기 위해 개발된 프로그램은 Fig. 9와 같다. 개발된 프로그램은 굽힘 감지 데이터 글러브와 PC 간의 Xbee 무선통신 전송속도, 채널, 데이터 글러브의 사용 여부, USB 포트 등을 설정하는 serial setting 기능과 각각의 손가락 굽힘 정도 및 마우스의 좌, 우 클릭 이벤트의 실행 여부를 확인하는 bend measurement 기능을 제공한다. 또한 키넥트 센서와 관련하여 tracking 관절에 대한 설정 기능, 사용자의 신체 부위에 대한 위치정보를 확인 기능, 실시간으로 송출된 컬러 영상 및 skeleton view의 가시화 기능을 제공한다.

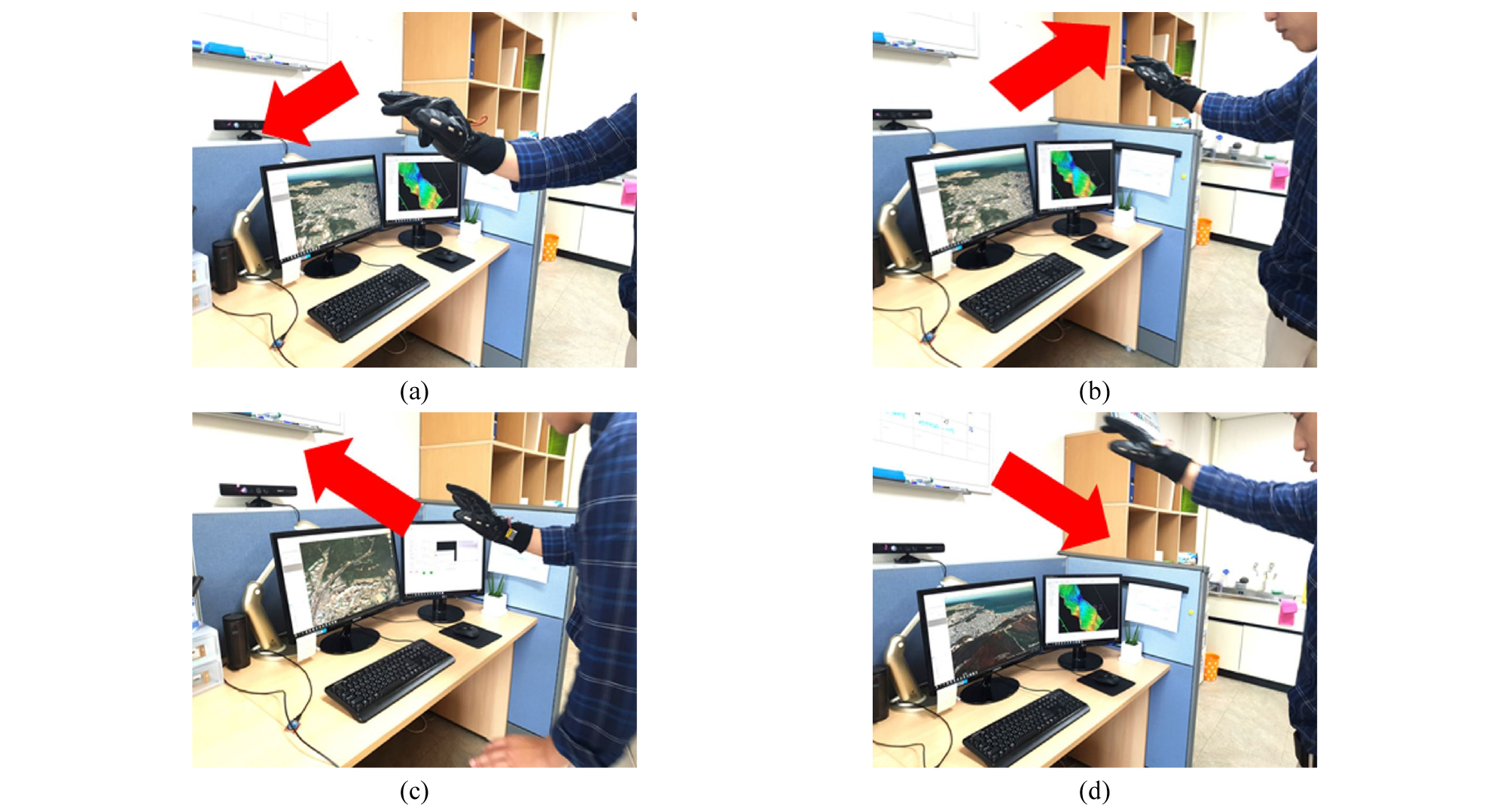

개발된 3D 사용자 인터페이스를 Intel i5 3570 CPU 3.40 GHz, 4 GB RAM, Intel(R) HD Graphics로 구성된 데스크톱 PC 환경에서 테스트하였다. 데스크톱 PC의 운영체제는 Windows 10을 사용하였다. 최근 광업 분야에서 초기 단계의 광체 탐사 및 노천광산 모니터링을 위해 빈번하게 사용하고 있는 Google Earth 소프트웨어를 3D 사용자 인터페이스를 이용하여 제어한 결과는 Fig. 10과 같다. 3D 사용자 인터페이스를 이용하여 3D 가시화 화면의 좌, 우 이동, 확대, 축소 등을 효율적으로 수행할 수 있었다.

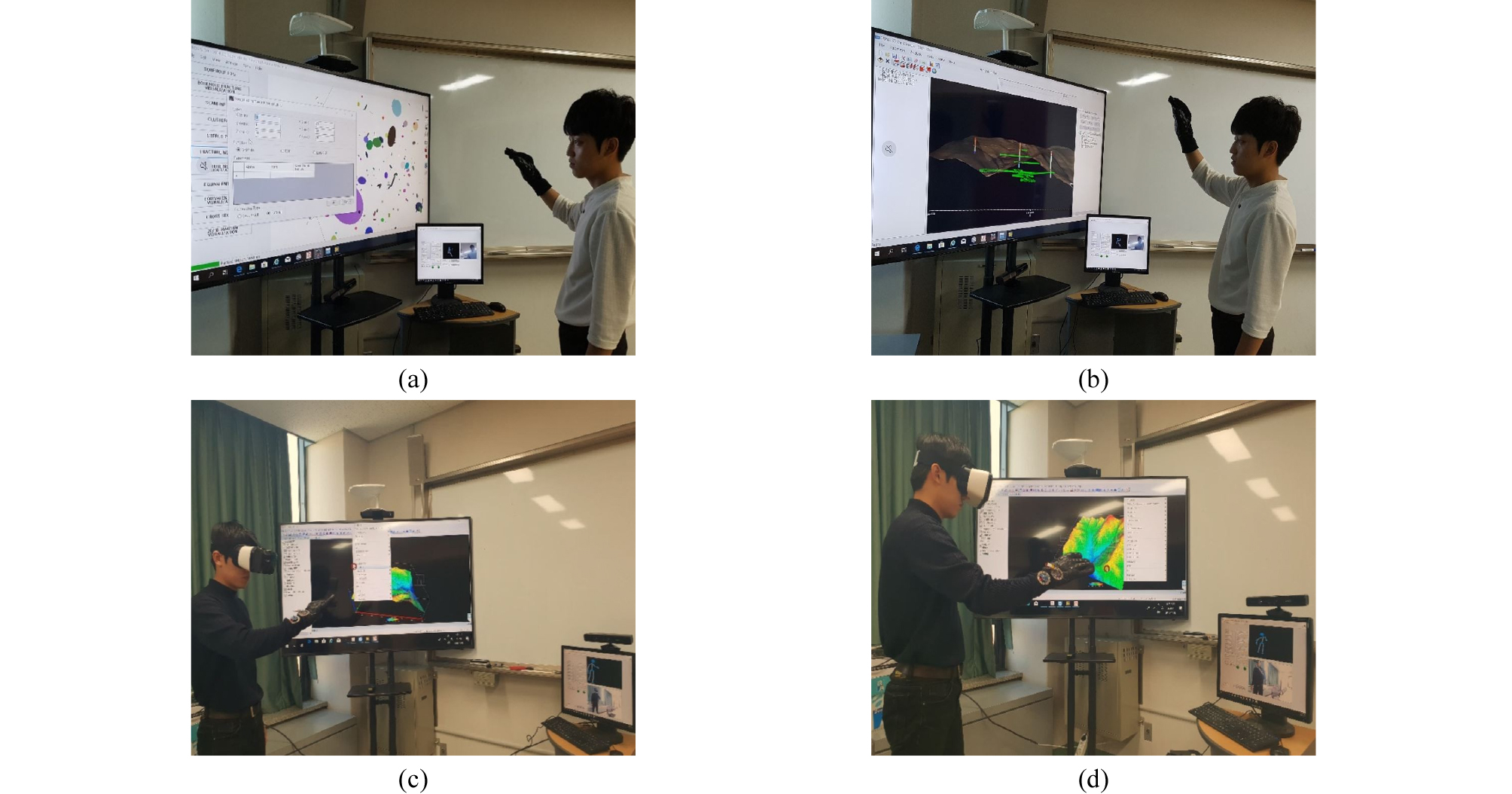

Fig. 11은 암반의 3D 미시구조를 시각화하는 FROMS 3D 소프트웨어, 시추자료로부터 3D 광체를 모델링하고 분석할 수 있는 Kmodstudio 소프트웨어, 광산의 지하수위 재상승 현상을 모델링 할 수 있는 Gram for Windows 소프트웨어를 개발된 3D 사용자 인터페이스를 이용하여 제어하는 모습을 보여준다. 개발된 3D 사용자 인터페이스를 테스트한 결과 키보드, 마우스 같은 전통적인 2D 사용자 인터페이스 장치를 사용하지 않고도 사용자의 신체 동작 및 손가락 움직임을 통해 광업 분야에서 사용되고 있는 소프트웨어들을 더욱 직관적으로 제어할 수 있었다.

결론

본 연구에서는 키넥트 센서와 굽힘 감지 데이터 글러브를 이용하여 지질 모델링, 광체 모델링, 광산 지하수위 모델링 등과 관련한 광업 분야 3D 소프트웨어를 직관적으로 제어할 수 있는 3D 사용자 인터페이스를 개발하였다. 키넥트 센서로 추적되는 사용자의 손 위치에 따라 Windows 환경에서 Win32 API 함수를 호출하여 마우스 커서의 위치를 제어하였으며, 굽힘 감지 데이터 글러브로 측정한 사용자 손가락의 구부러짐 정도에 따라 마우스 클릭 이벤트를 처리하였다. 개발된 3D 사용자 인터페이스를 데스크톱 PC 환경에서 테스트해 본 결과 Google Earth, FROMS 3D, Kmodstudio, GRAM for Windows와 같은 광업 분야 소프트웨어를 키보드와 마우스 없이도 직관적으로 제어할 수 있었다.

과거에 수행되었던 3D 사용자 인터페이스 개발은 사용자의 신체 동작을 키넥트 센서로 인식하여 소프트웨어 화면을 제어하거나 굽힘 감지 데이터 글러브만을 이용하여 소프트웨어 제어에 필요한 반복적인 이벤트들을 처리하였다. 본 연구에서는 키넥트 센서와 굽힘 감지 데이터 글러브를 함께 이용하고, 이들로부터 얻어지는 디지털 신호를 동시에 처리함으로써 두 입력장치의 장점을 모두 살릴 수 있는 3D 사용자 인터페이스 개발할 수 있었다.

현시점에서 본 연구에서 개발한 3D 사용자 인터페이스가 전통적인 2D 사용자 인터페이스인 키보드와 마우스를 완벽하게 대체할 수 있는 것은 아니다. 개발된 3D 사용자 인터페이스를 광업 분야 소프트웨어에 적용한 결과 3D 가시화 화면의 제어에는 효과적이었으나, 모델링 인자들을 설정할 때에는 여전히 키보드를 통한 문자 입력이 요구되었다. 또한 키넥트 센서는 사용자와 떨어진 거리 및 주변 광원의 세기에 따라 신체 동작 인식 능력에 차이가 있었고, 자체 개발한 굽힘 감지 데이터 글러브의 경우 손가락 굽힘 정도에 따라 센서의 측정값이 일정하지 않고 미세한 차이가 있었기 때문에 소프트웨어의 정밀한 화면 제어가 요구되는 경우에는 한계점을 나타내었다. 이러한 문제점들을 해결하기 위한 후속 연구가 필요하다. 또한 향후 연구로서 개발된 3D 사용자 인터페이스 장치를 다양한 소프트웨어에 적용할 시 각각의 소프트웨어별로 자주 필요한 동작의 제어를 찾아내는 부분과 사용상의 장점에 대한 분석이 필요하며, Hi5 VR Glove와 같이 현재 상용화된 데이터 글러브와 본 연구에서 개발한 굽힘 감지 데이터 글러브와의 비교실험을 통해 객관적인 성능평가도 시행되어야 할 것이다.

본 연구에서 확인한 것과 같이 3D 사용자 인터페이스는 사용자의 신체 동작을 이용하여 직관적으로 소프트웨어를 제어할 수 있는 장점이 있다. 최근 AR, VR 기술이 급속도로 발전하고 다양한 HMD 장치들이 상용화되면서 3D 사용자 인터페이스에 대한 수요가 커질 것이라 예상된다. 특히, 3D 자료의 처리와 활용이 대부분인 광업 분야 소프트웨어 시장에서는 3D 사용자 인터페이스 개발 및 활용이 더욱 중요할 것이다. 본 논문이 향후 광업 분야 3D 사용자 인터페이스 개발에 있어 유용한 참고자료가 될 수 있을 것이라 기대한다.