서 론

소형 자율주행 로봇의 개발 방법

자율주행 로봇의 구성

라이다 센서의 원리와 기능

라이다 센서를 이용한 조향 제어

블루투스 비콘을 이용한 정지 제어

실내 모사 실험 방법

실내 모사 실험장 구성

조향 제어 조건 설정

주행 실험 방법

실내 모사 실험 결과

결 론

서 론

전 세계적으로 자율주행 기술에 관한 관심이 커지면서 이를 실용화하기 위한 다양한 노력이 진행되고 있다(Kim and Huh, 2018). 대표적으로 일본 닛산 자동차에서는 2017년 자율주행 차량의 프로토타입(prototype)을 공개했으며, 2022년까지 완전 자율주행 자동차를 출시할 예정이다(COMPA, 2018). 현대자동차에서는 국내 최초로 도심형 자율주행 자동차를 선보였으며, 2030년까지 완전한 자율주행 자동차 개발을 목표로 하고 있다(HYUNDAI, 2019).

최근 광업 분야에서도 자율주행 기술을 현장에 도입하기 위한 다양한 연구들을 수행하고 있다. 특히, 해외에서는 지하광산에서 운용 가능한 자율주행 로봇 시스템 개발에 관한 연구들이 다수 수행되었다. Baker et al.(2004)은 라이다(Light Detection and Ranging, LiDAR) 센서와 환경 인식 센서를 활용한 자율주행 로봇을 개발하였고, 폐광산을 대상으로 한 실험에서 안정적인 주행성능을 확인하였다. Bakambu and Polotski(2007)는 2개의 라이다 센서를 활용하여 장애물을 인식하면서 지하갱도에 대한 2, 3차원 맵핑 작업을 수행할 수 있는 자율주행 시스템을 개발하였다. Chi et al.(2012)은 라이다 센서와 바코드 인식기술을 활용하여 지하광산 환경에서 활용될 수 있는 자율주행 로봇을 개발하였다. Ghosh et al.(2016)은 라이다 센서와 로봇의 움직임 정도를 측정할 수 있는 센서들을 활용하여 지하광산을 3차원으로 맵핑할 수 있는 자율주행 시스템을 개발하였다. 그 외에도 지하광산 현장에서 자율주행 로봇을 활용하여 안전관리나 광석운반 작업을 수행하기 위한 연구도 다수 수행되었다(Larsson et al., 2005; Marshall et al., 2008; Zhao et al., 2017; Günther et al., 2019; MobileTronics, 2019).

해외와는 달리 국내에서는 광업 분야에서 활용할 수 있는 자율주행 기술과 관련한 연구가 매우 미흡한 실정이다. 국내에서도 해외에서 제작된 상용 자율주행 로봇 시스템들을 구매할 수는 있지만, 매우 고가이므로 영세한 규모의 국내 광산 현장에 도입하기는 쉽지 않다. 또한, 해외의 상용 제품들은 대부분 자율주행 알고리즘이나 제어 코드를 공개하지 않기 때문에 이 분야의 국내 기술 자립화에도 도움이 되지 못한다. 따라서 국내에서도 상대적으로 제작이 쉬운 소형 자율주행 로봇을 시작으로 광산 현장에서 활용 가능한 다양한 로봇 시스템에 관한 연구가 필요하다고 판단된다.

본 연구의 목적은 라이다 센서 기반의 소형 자율주행 로봇을 개발하고, 지하광산 갱도 환경을 모사한 실내 실험장에서 주행성능 실험을 수행하는 것이다. 실시간으로 거리측정이 가능한 라이다 센서를 활용하여 좌, 우측 벽면까지의 거리를 측정하여 거리 차이에 따라 자율주행 로봇의 조향이 제어될 수 있도록 할 것이다. 또한, 블루투스 비콘(Bluetooth beacon)을 활용하여 로봇이 목적지에 근접했을 때 자동으로 정지할 수 있도록 할 것이다. 본 논문에서는 지하광산용 소형 자율주행 로봇의 개발 방법을 설명하고, 넓어지는 구간, 좁아지는 구간, 직선 구간, 곡선 구간으로 구성된 실내 실험장에서 개발된 자율주행 로봇의 주행성능을 실험한 결과를 제시한다.

소형 자율주행 로봇의 개발 방법

자율주행 로봇의 구성

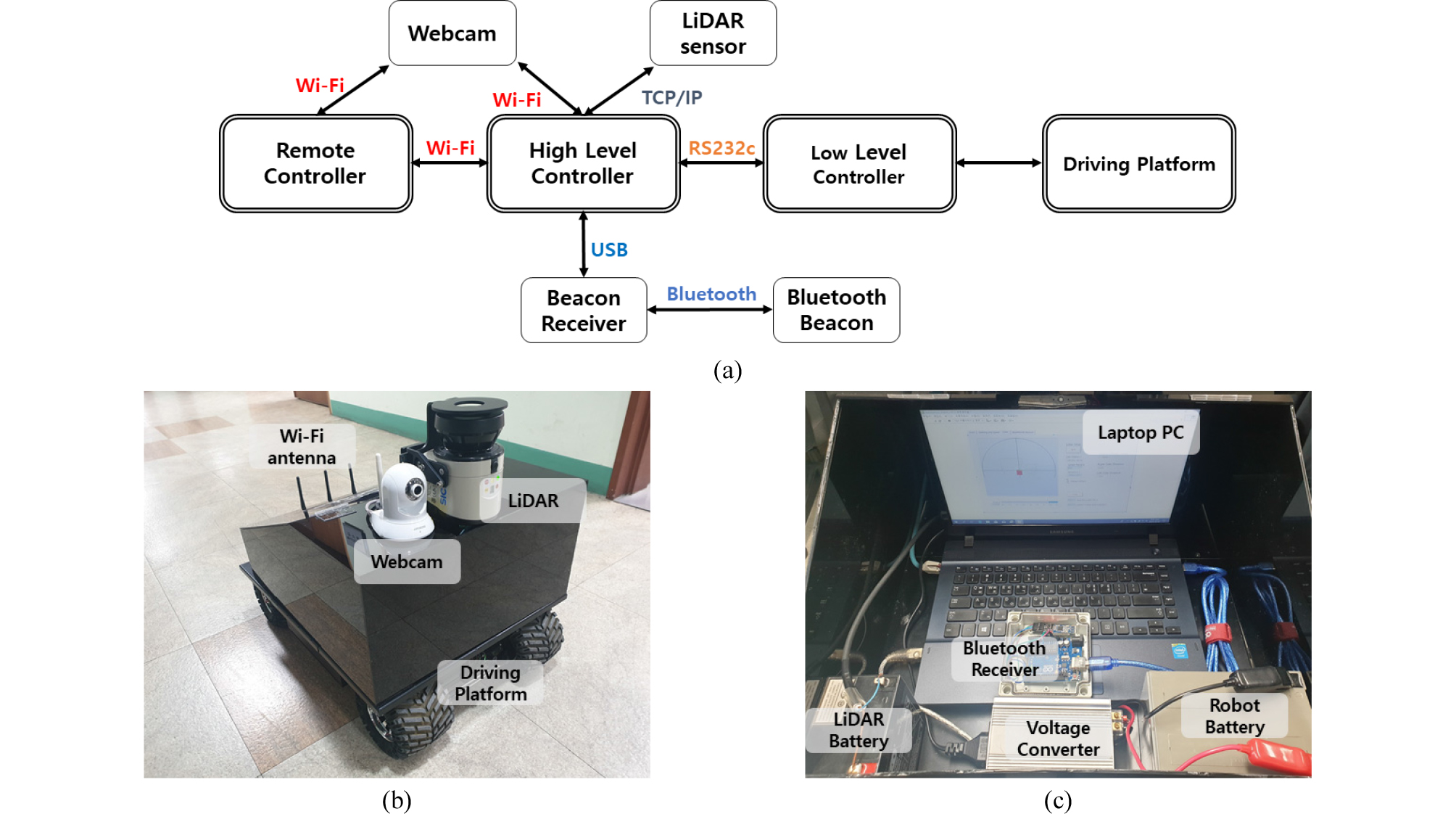

Fig. 1은 본 연구에서 개발한 소형 자율주행 로봇의 전체적인 구조와 내, 외부 모습을 보여준다. 자율주행 로봇은 주행 플랫폼(driving platform), 하위/상위/원격 컨트롤러(low/ high/remote controllers), 센서들로 구성된다(Fig. 1(a)). 본 연구에서는 주행 플랫폼으로 언맨드솔루션의 ERP-42 (Unmanned Solution, 2019)를 사용하였다. ERP-42는 4개의 바퀴로 사륜구동이 가능한 주행 플랫폼이다. Table 1은 ERP-42 주행 플랫폼의 사양을 보여준다.

Table 1. Specifications of the ERP-42 platform (Unmanned Solution, 2019)

주행 플랫폼의 모터를 제어하기 위한 하위 컨트롤러로는 ATMEL의 AVR 마이크로 컨트롤러 ATMega128(MICROCHIP, 2019)을 사용하였다. 상위 컨트롤러로는 Intel Celeron (R) CPU 1007U 1.50 GHz, 4 GB RAM, Intel(R) HD Graphics 사양의 노트북 PC와 Windows 10 운영체제를 사용하였다. 상위 컨트롤러는 로봇의 움직임을 확인함과 동시에 사용자가 원하는 방식으로 하위 컨트롤러를 제어할 수 있도록 하였다. 원격 컨트롤러는 Intel Atom(TM) CPU N2600 1.60 GHz, 2 GB RAM, Intel(R) Graphics Media Accelerator 3600 Series 사양의 노트북 PC와 Windows 7 운영체제를 사용하였다. 원격 컨트롤러는 로봇과 떨어져 있는 곳에서 상위 컨트롤러와 Wi-Fi 통신으로 연결되며, 원격으로 로봇을 조종할 때 사용하였다.

로봇의 외부(Fig. 1(b))에는 지하광산 주행 환경에서 발생할 수 있는 물리적인 충격과 누수로부터 내부 장비들을 보호하기 위해 아크릴 소재의 덮개를 설치하였다. 덮개 외부 전방에는 라이다 센서와 웹캠을 설치하였고, 후방에는 웹캠을 통해 입력받는 영상을 원격 컨트롤러에 실시간으로 전송하기 위해 Wi-Fi 안테나를 설치하였다. 덮개 내부(Fig. 1(c))에는 상위 컨트롤러인 노트북 PC와 하위 컨트롤러인 로봇 제어 보드를 배치하였고, 이들은 USB 케이블을 이용해 연결하였다. 자율주행 로봇 시스템에 전력을 공급하기 위하여 12 V 납축전지 2개를 덮개 내부에 적재하였다.

라이다 센서의 원리와 기능

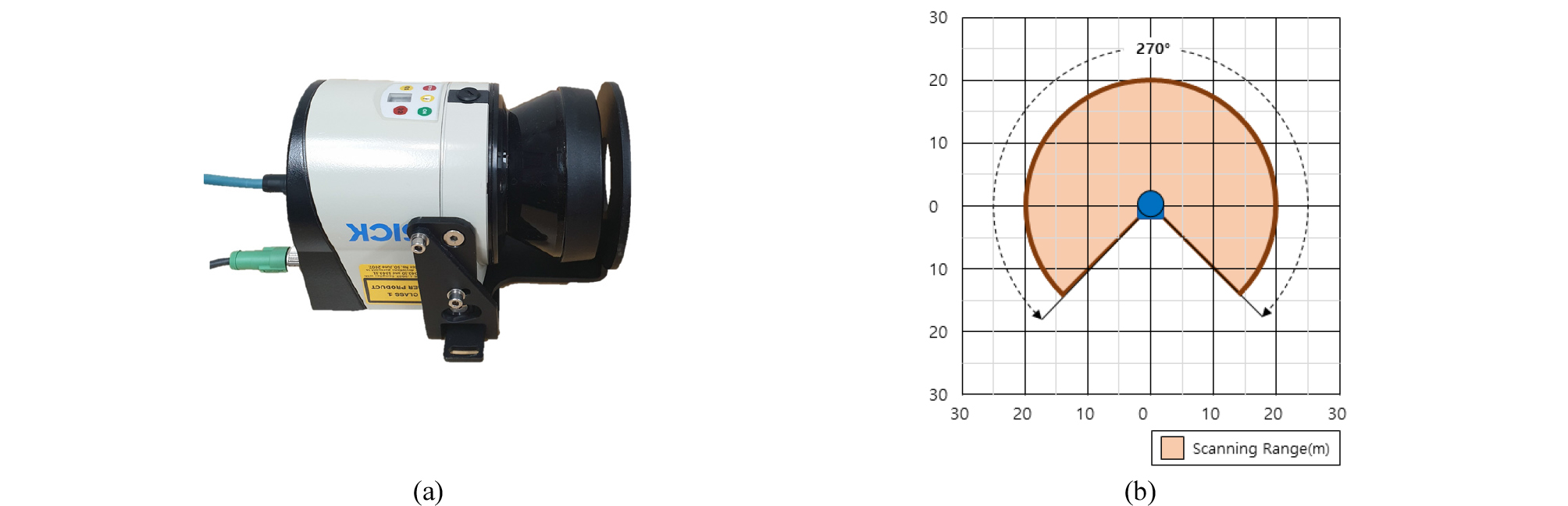

라이다 센서는 레이저 빛을 발사한 후 반사되어 돌아오는 빛을 수신하여 대상지점까지의 거리와 방향을 측정한다(Kim et al., 2012). 본 연구에서는 SICK의 2D 라이다 센서인 LMS-111(SICK, 2019)을 사용하였다. LMS-111은 10.8 V∼30 V의 직류 전압을 사용하며, TCP/IP 통신을 통해 10∼100 Mbit/s의 속도로 데이터를 전송할 수 있다. 또한, 수평 270° 지역을 0.25° 간격으로 측정할 수 있으며 권장 작업 범위는 50 cm∼20 m이다. 50 cm 미만 거리에서도 측정은 가능하지만, 상대적으로 높은 측정오차를 보인다. Fig. 2는 LMS-111 센서의 외관과 탐지범위를 보여준다.

본 연구에서는 라이다 센서에서 측정된 거리정보를 TCP/IP 통신을 통해 상위 컨트롤러에서 실시간으로 수신할 수 있도록 하였다. 라이다 센서를 통해서 좌, 우측 벽면까지의 거리를 측정할 때에는 좌, 우전방 35° 지점의 거리를 측정함으로써 전방의 도로 상황을 인지할 수 있도록 하였다.

라이다 센서를 이용한 조향 제어

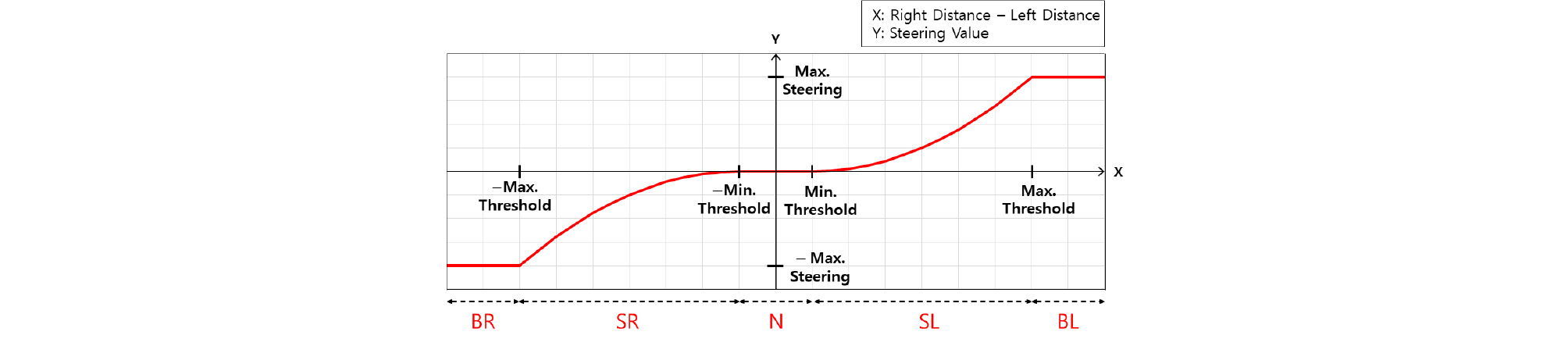

본 연구에서는 자율주행 로봇에 탑재된 라이다 센서로부터 측정된 좌, 우측 벽면까지의 거릿값을 활용하여 이동 플랫폼의 조향을 제어하였다. Fig. 3은 라이다 센서에서 얻어지는 좌, 우측면까지의 거리 차이에 따른 로봇의 조향 값을 나타내는 그래프이다. 여기서 X축은 로봇에서 측정한 우측 벽면까지의 거리에서 좌측벽면까지의 거리를 뺀 값이며, Max.Threshold와 Min.Threshold는 각각 자율주행 로봇의 조향 값이 최대가 되는 X값과 조향이 변하기 시작하는 X값을 나타낸다. Y축에서 Max.Steering은 자율주행 로봇의 최대 조향 값이며, (+)는 우측, (‑)는 좌측을 의미한다.

X값에 따른 로봇의 위치는 다음과 같이 BR(Big Right), SR(Small Right), N(Normal), SL(Small Left), BL(Big Left)로 분류하였다.

∙ BR: X가 –Max.Threshold 미만의 값을 가지고, 좌측벽면까지의 거리가 우측 벽면까지의 거리보다 매우 커서 로봇이 갱도 우측면에 밀착되어있는 상태이다. 이때는 Y가 –Max.Steering 값을 가진다.

∙ SR: X가 –Max.Threshold 이상, –Min.Threshold 미만의 값을 가지며, 좌측벽면까지의 거리가 우측 벽면까지의 거리보다 커서 로봇이 갱도 중심과 우측면 사이에 있는 상태이다.

∙ N: X가 –Min.Thrshold 이상, Min.Threshold 미만의 값을 가지고, 로봇이 갱도 중심선 근처에 있는 상태이다.

∙ SL: X가 Min.Threshold 이상, Max.Threshold 미만의 값을 가지고, 우측 벽면까지의 거리가 좌측벽면까지의 거리보다 커서 로봇이 도로 중심과 좌측면 사이에 있는 상태이다.

∙ BL: X가 Max.Threshold 이상의 값을 가지고, 우측 벽면까지의 거리가 좌측벽면까지의 거리보다 매우 커서 로봇이 갱도 좌측면에 밀착되어있는 상태이다. 이때는 Y가 Max.Steering 값을 가진다.

Table 2는 상태별 좌, 우거리 차이(X)에 따라 출력되는 조향 값(Y)의 계산식을 나타낸다. 조향 값은 –Max.Steering과 Max.Steering 사이의 값을 가지며, 실제 로봇의 회전 각도는 계산된 조향 값에 0.1을 곱해준 것과 같다. X가 Max.Threshold 이상일 때 조향은 Max.Steering 값을 가지며, –Max.Threshold 이하일 때 –Max.Steering 값을 가지도록 설계하였다. X가 –Min.Threshold 이상, Min.Threshold 이하일 경우에는 좌, 우측 벽면까지의 거리 차가 크지 않다고 판단하여 로봇의 조향을 변경시키지 않았다. 이는 로봇이 주행 중에 지나치게 조향을 자주 변경하는 것을 방지하기 위한 것이다. 본 연구에서는 LabVIEW 소프트웨어(NATIONAL INSTRUMENTS, 2019)를 이용하여 제시된 알고리즘을 구현하여 상위 컨트롤러에 설치하였다.

Table 2. Equations for calculating the steering values (Y) at different positions of the autonomous driving robot developed in this study

블루투스 비콘을 이용한 정지 제어

블루투스 비콘은 BLE(Bluetooth Low Energy) 기술을 기반으로 주변 기기들에 정기적으로 무선 신호를 송신한다(Baek et al., 2018). 본 연구에서는 자율주행 로봇의 정지 제어를 위해 블루투스 비콘을 사용하였다. Perples에서 개발한 RECO 비콘(RECO, 2019)을 자율주행 로봇의 도착지점에 설치하였고, 비콘으로부터 송신되는 신호를 수신하기 위하여 오픈소스 하드웨어인 아두이노 HM-10 모듈(COMPONENTS101, 2019)을 자율주행 로봇에 탑재된 상위 컨트롤러에 연결하였다. 자율주행 로봇이 블루투스 비콘에 가까이 갈수록 수신되는 신호의 크기를 나타내는 RSSI(Received Signal Strength Index) 값이 커진다. 따라서 수신되는 신호의 RSSI 값을 분석하여, 특정 임계값 이상으로 값이 커지면 자율주행 로봇이 목적지에 도착한 것으로 판단하고 정지할 수 있도록 제어하였다.

실내 모사 실험 방법

본 연구에서는 라이다 센서 기반 자율주행 로봇의 주행 정확도를 측정하기 위해 지하광산 갱도 환경을 모사한 실내 실험을 수행하였다. 실내 실험장에서 로봇이 정해진 경로에 따라 자율주행하는 것을 10회 반복 실험하였고, 이를 영상으로 촬영하여 주행 정확도를 분석하였다.

실내 모사 실험장 구성

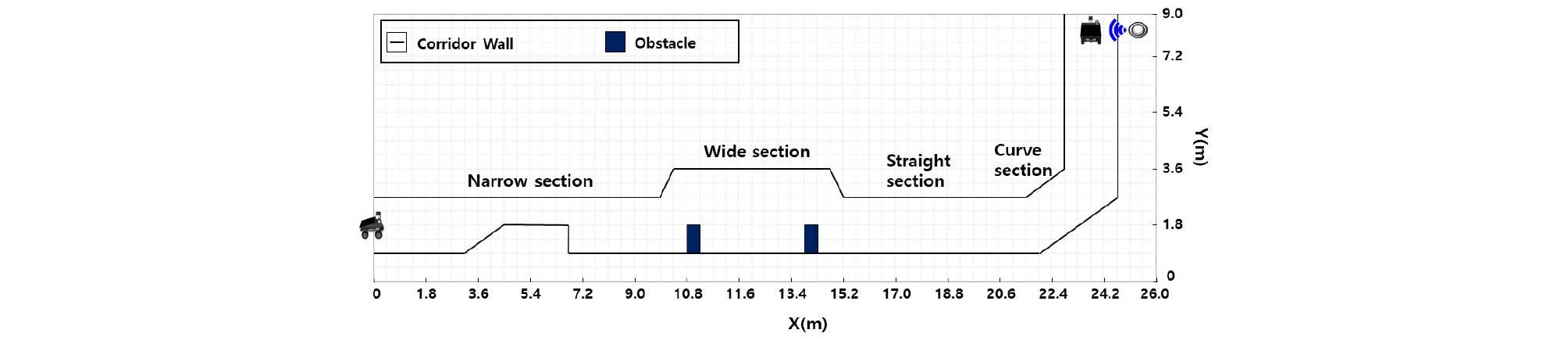

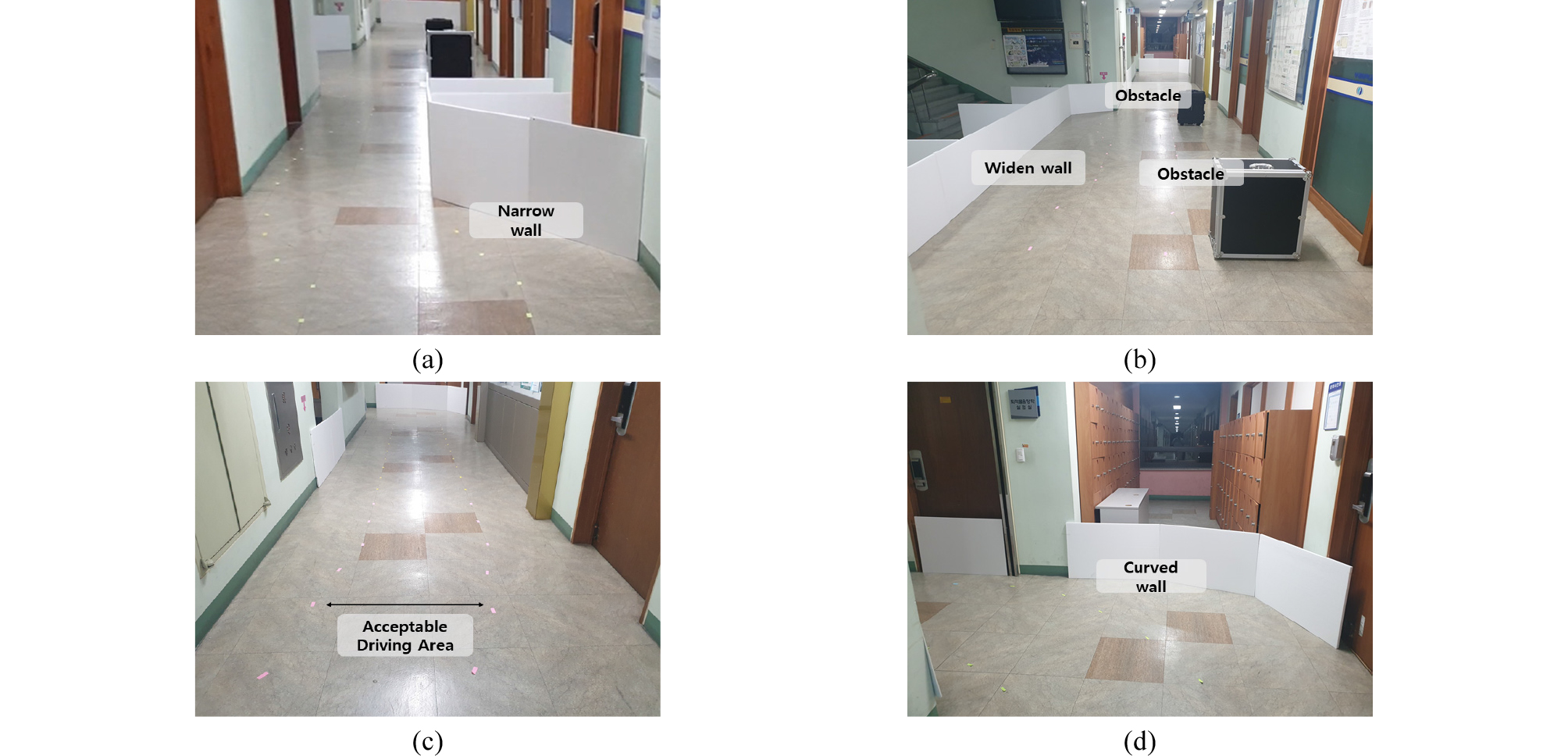

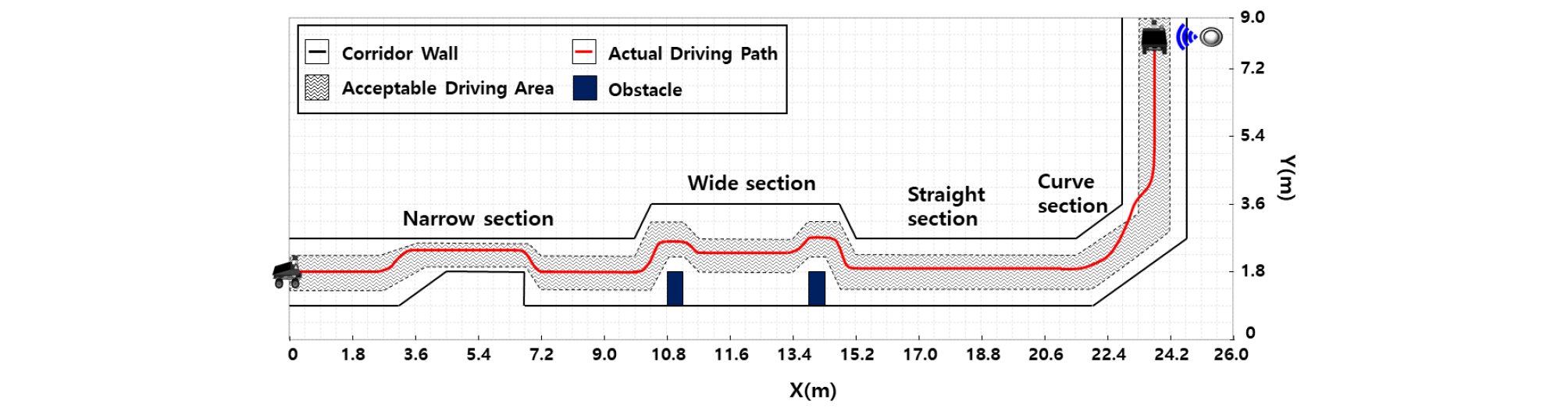

개발된 자율주행 로봇의 주행 정확도를 분석하기 위해서 Fig. 4와 같이 폭 2.5 m, 높이 2.6 m, 총 길이 30 m 규격의 실내 모사 실험장을 설계하였다. Fig. 5는 실내 모사 실험장의 사진을 보여준다. 실험장은 도로의 폭이 좁아지는 구간(Fig. 5(a)), 도로의 폭이 넓어지는 구간(Fig. 5(b)), 직선 구간(Fig. 5(c)), 곡선 구간(Fig. 5(d))으로 구성된다. 도로의 폭이 좁아지는 구간과 넓어지는 구간을 설정하기 위해 실내에 임시 벽면을 설치하였다. 자율주행 로봇에 탑재된 라이다 센서가 60 cm의 높이에 위치하여 있으므로, 임시 벽면의 높이도 60 cm 이상이 될 수 있도록 설계하였다. 도로의 폭이 넓어지는 구간에서는 주행 방향 전방에 가로 1 m, 세로 0.5 m 크기의 장애물 2개를 배치하여 자율주행 로봇의 전방 장애물 회피 기동 능력도 시험하였다. 자율주행 로봇의 예상되는 이동 경로를 중심으로 로봇 좌, 우측 20 cm 버퍼 존(buffer zone)을 허용 주행영역(acceptable driving area)으로 설정하였고, 실험 결과에 대한 영상 분석이 쉽도록 도로의 바닥에 영역 경계선을 표시하였다. 실험이 종료되는 지점에는 블루투스 비콘을 설치하여 자율주행 로봇이 자동으로 정지할 수 있도록 하였다.

조향 제어 조건 설정

자율주행 로봇의 조향 제어와 관련하여 Table 2에 제시된 임계값들은 실내 모사 실험장의 환경에 맞추어 설정하였다. 먼저, Max.Threshold는 로봇이 도로의 1/4 지점에 있었을 때 최대 조향각으로 회전하도록 가로 폭의 절반인 1.25 m로 설정하였다. Min.Threshold는 실험장 일부 구간에서 나타나는 20 cm 깊이의 문턱을 고려하여 20 cm로 설정하였다.

주행 실험 방법

출발지점에서 원격 컨트롤러의 주행 시작 버튼을 누르면 자율주행 로봇이 4 km/h의 속도로 이동을 시작한다. 이후 로봇은 라이다 센서의 측정값들을 실시간으로 비교하면서 자동으로 조향을 조정하며 도착지점까지 자율주행으로 이동한다. 도착지점에 근접한 로봇은 블루투스 비콘의 신호를 수신하여 자동으로 정지한다. 실내 모사 실험장에서 이와 같은 시나리오의 자율주행을 총 10회 수행하였고, 실험과정을 영상으로 촬영한 후 주행 정확도를 분석하였다.

실내 모사 실험 결과

Fig. 6은 개발된 자율주행 로봇이 실내 실험장에서 주행하는 모습을 보여준다. 자율주행 로봇은 좁아지는 구간, 넓어지는 구간, 직선 구간, 곡선 구간을 벽면이나 장애물과의 충돌 없이 안전하게 주행하였다. 또한, 도착지점에서는 블루투스 비콘의 신호를 수신하여 별도의 제어 없이 자동으로 정지할 수 있었다. 로봇이 전체 실험장을 주행하는 데에는 평균적으로 약 1분의 시간이 소요되었다.

10회의 실험은 동일한 환경에서 수행되었다. 실험 결과, 자율주행 로봇은 모든 실험에서 유사한 경로로 주행하였다. Fig. 7은 총 10회의 실험 중, 첫 번째 실험 결과를 보여준다. 자율주행 로봇의 이동 경로를 분석한 결과 실험장 전체 구간 중 곡선 구간 일부를 제외한 모든 구간에서 허용 주행영역 내에서 이동하였다. 좁아지는 구간에서는 폭이 좁아진 도로의 중심선을 따라서 주행하였으며, 넓어지는 구간의 경우 구간의 시작 지점과 끝 지점에 세워진 장애물을 미리 인지한 후 안전하게 회피하는 것을 확인할 수 있었다. 직선 구간을 지나 곡선 구간에 진입할 때에는 허용 주행영역 내에서 이동하였으나, 곡선 구간이 끝나는 일부 구간에서 잠시 허용 주행영역을 벗어나는 모습을 보였다. 그러나 도로의 벽면으로부터 충분한 거리를 두고 이동하였기 때문에 곡선 구간에서도 벽면과 충돌하는 사고는 발생하지 않았다.

Table 3은 10회 주행 실험 결과를 요약한 것이다. Lane Keeping(%)은 총 10회의 주행 실험에서 자율주행 로봇이 허용 주행영역 안에서 이동한 거리를 전체 이동 거리로 나누어 계산한 결과이다. 좁아지는 구간과 넓어지는 구간에서는 100% 허용 주행영역 안에서 자율주행 로봇이 이동하였다. 직선 구간에서도 허용 주행영역 안에서 주행한 비율이 98.46%로 자율주행 로봇이 안정적인 주행성능을 보였다. 그러나 곡선 구간에서는 허용 주행영역 안에서 주행한 비율이 61.25%, 허용 주행영역을 벗어난 비율이 38.75%로 주행 정확도가 다소 떨어지는 것을 확인할 수 있었다.

Table 3. Results from 10 indoor experiments of the autonomous driving robot.

| Section | Narrow section | Wide section | Straight section | Curved section | Whole section |

| Lane Keeping (%) | 100 | 100 | 98.46 | 61.25 | 94.64 |

본 연구에서 개발된 자율주행 로봇은 라이다 센서를 이용하여 좌, 우측 전방 35° 지점의 거리를 측정하면서 조향을 조정한다. 따라서 로봇이 곡선 구간을 지날 때는 라이다 센서로 우측은 로봇에서 가까운 곳에 있는 벽면까지 거리를 측정하는 데 반해, 좌측은 곡선 구간의 좌측벽면을 넘어 직선 구간에 있는 벽면까지의 거리를 측정한다. 그 결과 좌측벽면까지의 거리가 우측 벽면까지의 거리보다 크게 긴 것으로 측정되어, 로봇의 조향이 좌측으로 크게 회전하였고 이때 허용 주행영역을 벗어난 것으로 판단된다.

곡선 구간에서 발생하는 주행 오차를 줄이기 위해서는 라이다 센서를 이용하여 특정 지점의 거리를 측정하는 것뿐만 아니라, 전반적인 도로의 형태를 인식하여 로봇의 조향을 조정해야 할 것이다. 즉, 도로의 형태가 곡선으로 인식될 때는 도로의 휘어진 정도에 따라 로봇의 조향이 출력될 수 있는 개선된 주행 알고리즘을 적용해야 할 것으로 판단된다.

결 론

본 연구에서는 실시간으로 거리를 측정할 수 있는 라이다 센서를 이용하여 지하광산 환경에 적용될 수 있는 소형 자율주행 로봇을 개발하였다. 개발된 로봇은 라이다 센서를 이용해 좌, 우측 전방 35° 지점의 벽면까지 거리를 측정한다. 측정된 좌, 우측 거리의 차이에 따라 로봇의 위치를 BR(Big Right), SR(Small Right), N(Normal), SL(Small Left), BL(Big Left)로 분류하고, 분류에 따라 로봇의 조향을 제어한다. 자율주행 로봇이 목적지에 근접하면 블루투스 비콘의 송신하는 신호를 수신하여 별도의 제어 없이도 로봇이 자체적으로 정지할 수 있다.

일반적인 자율주행 로봇은 위성항법시스템(Global Positioning System, GPS)과 비전 카메라를 활용하여 로봇의 위치와 주변의 전방적인 환경을 인지한다. 그러나 지하광산에서는 GPS를 이용한 위치 인식이 불가능하며, 일정한 세기의 광원을 확보하는 것이 어려워서 비전 카메라의 활용성이 떨어진다. 이러한 이유로 본 연구에서는 광원이 없는 지하광산에서도 사용할 수 있는 라이다 센서와 블루투스 비콘을 사용하여 자율주행 로봇의 조향 및 정지 제어를 시도하였다. 그 결과 지하광산을 모사한 실내 실험장에서 안정적인 자율주행 성능을 확인할 수 있었다.

지하광산 갱도를 모사한 실내 실험장에서 총 10회의 반복 주행 실험을 수행한 결과 넓어지는 구간, 좁아지는 구간, 직선 구간에서 허용 주행영역 내에서 이동하는 안정적인 주행성능을 보여주었다. 곡선 구간에서는 허용 주행영역을 벗어나는 모습도 보였으나 도로의 벽면과 충돌하는 사고는 발생하지 않았다. 곡선 구간에서 자율주행 로봇의 주행성능을 개선하기 위해서는 라이다 센서로 좌, 우측 벽면까지의 거리를 측정하는 것뿐만 아니라, 곡선 구간의 곡률을 인지할 수 있어야 할 것이다. 또한, 곡선 구간의 곡률에 따라 안정적으로 주행할 수 있는 조향 제어 알고리즘의 개발이 필요하다.

실내 모사 실험장과는 달리 실제 지하광산은 도로의 형태가 일정하지 않고, 벽면의 거칠기가 크다. 또한, 노면 굴곡에 따른 진동이나 주행 속도에 따른 오차 등이 발생할 수 있다. 갱도 내에서 상차와 하차가 만나는 경우도 발생하며, 트럭과 같은 운반 장비의 경우 도착지점에서 회차하여 선광장이나 파쇄장으로 돌아오는 경우도 발생한다. 따라서 이러한 환경적 변화를 반영할 수 있도록 자율주행 알고리즘을 개선해야 할 것이다. 이를 위한 추가적인 연구가 필요하다.